AI应用大咖说:多相机的时空融合模型架构算法优化

2022/12/23 13:59:07 来源:中国企业新闻网

导言:随着人工智能技术的广泛应用,智能驾驶系统正在成为汽车的标配。而作为识别周边环境的“火眼金睛”,“感知”模块是智能驾驶系统安全、高效运行的核心,而视觉感知更是其中无比重要的一环。

随着人工智能技术的广泛应用,智能驾驶系统正在成为汽车的标配。而作为识别周边环境的“火眼金睛”,“感知”模块是智能驾驶系统安全、高效运行的核心,而视觉感知更是其中无比重要的一环。浪潮信息AI团队长期关注AI算法在自动驾驶中的应用,并致力于用软硬件的算法和技术创新推动行业的进步,做出创新性的成绩。最近,浪潮信息在自动驾驶感知权威数据集 NuScenes 评测中,自研算法 DABNet4D 获得 0. 624 的NDS精度,位列Camera-only榜单第一名。

近日,浪潮信息人工智能与高性能应用软件部自动驾驶AI研究员赵云博士,在题为《探索自动驾驶纯视觉感知精度新突破 -- 多相机的时空融合模型架构算法优化》的自动驾驶线上研讨会上,向我们揭开了这一自动驾驶感知算法的神秘面纱。

多相机多任务融合模型优势

自动驾驶汽车完成自动驾驶出行任务,离不开感知、决策、控制三大要素。其中感知系统是车辆和环境交互的纽带,相当于无人汽车的眼睛。根据所用的传感器以及传感器数量和种类等,自动驾驶感知算法可以简单的分为单传感器(单任务和多任务)模型、(同类和不同类)传感器融合模型等四类,并各有其优缺点。

自动驾驶感知的关键是3D目标检测任务,又分为基于相机、Lidar的3D目标检测,以及相机、Lidar、Radar融合等技术。尽管目前对于3D目标检测已经有不少的研究,但是在实际应用中仍然有许多的问题,其难点主要在于:

遮挡,遮挡分为两种情况,目标物体相互遮挡和目标物体被背景遮挡

截断,部分物体被图片截断,在图片中只能显示部分物体

小目标,相对输入图片大小,目标物体所占像素点极少

缺失深度信息,2D图片相对于激光数据存在信息稠密、成本低的优势,但是也存在缺失深度信息的缺点

现有方式大都依赖于物体表面纹理或结构特征,容易造成混淆。

目前,基于相机的方法与基于Lidar的方法准确度差距正在缩小,而随着Lidar成本降低,融合技术在成本和准确度的平衡上存在优势。

基于多相机多任务融合模型的3D目标检测技术正是在成本优势与日益增长的准确度两相促进下得到越来越多的认可。目前,多相机多任务融合模型主要遵循特征提取、特征编码、统一BEV、特征解码和检测头五大部分。

其中,统一BEV 就是鸟瞰图,亦即将图像特征统一投射到BEV视角下,用以表示车周围环境。“统一BEV”的工作可以分为两大类,一种基于几何视觉的变换,也就是基于相机的物理原理,优势在于模型确定,难度在深度估计;另一种是基于神经网络的变换。

浪潮DABNet4D算法三大创新突破

据赵云介绍,浪潮DABNet4D算法遵循上述框架,采用基于几何视觉的变换方法,设计了端到端的模块化整体架构,通过将环视图检测统一到BEV空间,为后续的工作提供了很好的模板。

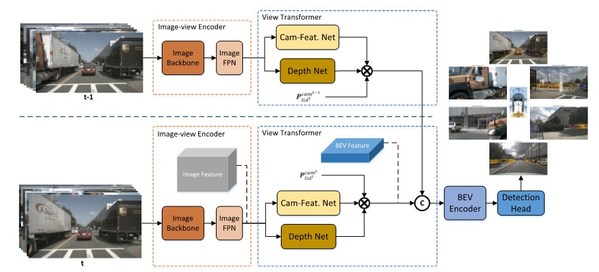

DABNet4D模型被划分为四个部分,Image-view Encoder,View-transformer,BEV-Encoder,Detection Head。其中Image-view Encoder为图像编码模块将原始图像转换为高层特征表示。 View-Transformer模块负责将图像特征转换到BEV坐标中,主要包括三个模块:深度预测模块、特征转换模块和多帧特征融合模块。BEV-Encoder & Heads主要是对融合BEV特征进行编码;Heads用来完成最终的3D目标检测任务。

创新突破一 数据样本增强

为平衡不同种类的样本数量,浪潮信息AI团队创新研发了基于3D的图像贴图技术。主要是通过从整个训练数据集中根据每个样本的3D真值标签,提取样本数据构建样本数据库。训练过程中,通过在样本数据库中采样获取备选样本集合,按照真值深度值从远至近贴图,并将对应的Lidar数据进行粘贴。

创新突破二 深度信息优化

基于图像的3D目标检测,由于摄像头拍摄的照片和视频是将原有3D空间直接投射至2D平面中,所以会丢失深度信息,由此所面临的核心问题为如何精确地估计图像中物体的深度。针对此问题,浪潮信息AI团队进行了两方面的改进工作:一是建立更复杂的深度估计网络,通过设计更深、更多参数的深度神经网络,以增大深度估计网络的预测能力和感受野;二是采用两层级联深度估计网络结构,第一层估计网络估计的深度作为特征,输入到第二层级联网络中。除了进行网络创新设计优化,在训练阶段也采用深度监督、深度补全、损失函数等优化方法。

创新突破三 四维时空融合

对于自动驾驶车辆而言,它所处的环境更像是一个动态变化的三维空间。为进一步引入车辆所处的动态中的历史,通过引入时间信息进行时序融合,提升velocity预测的精度,实现对暂时被遮挡的物体更好的跟踪效果。对此,浪潮信息AI团队做了以下几点创新:1、更精细的时空对齐操作,使前后帧特征结合的更精确。根据不同时刻车辆的位姿以及车辆、相机、Lidar坐标系的转换关系,获取不同时刻相机与指定Lidar的坐标系的转换关系,进一步减少由于采集车辆自身运动对多帧BEV特征对齐带来的影响;2、从sweep数据帧随机选取作为前一帧与当前帧进行匹配,大幅地增强数据的多样性;3、不同时序帧同步进行数据样本贴图增强,使得速度、转向等预测更精准。

致胜NuScenes自动驾驶评测

本次浪潮DABNet4D算法所登顶的自动驾驶NuScenes榜单,其数据集包含波士顿和新加坡两大城市收集的大约15小时的驾驶数据,覆盖了城市、住宅区、郊区、工业区各个场景,也涵盖了白天、黑夜、晴天、雨天、多云等不同时段不同天气状况。数据采集传感器包括了6个相机、1个激光雷达、5个毫米波雷达、以及GPS和IMU,具备360°的视野感知能力。

NuScenes数据集提供二维、三维物体标注、点云分割、高精地图等丰富的标注信息。目前,基于NuScenes数据集的评测任务主要包括3D目标检测(3D object Detection)、3D目标跟踪(3D object Tracking)、预测轨迹(prediction trajectories)、激光雷达分割(Lidar Segmentation)、全景分割和跟踪(lidar Panoptic segmentation and tracking)。其中3D目标检测任务备受研究者关注,自从NuScenes挑战赛公开以来至今,已提交220余次结果。

浪潮DABNet4D算法在训练与评测过程中使用的底层硬件支撑是浪潮NF5488A5 AI服务器。开发过程中,模型在训练集上进行单次训练运行 20 个 epochs(without CBGS),需要耗费 约360 个 GPU 小时。

而为了满足此类算法超高的AI算力需求,浪潮信息提供集群解决方案,采用 Spine-Leaf 的结构进行节点扩展,集成超 2000 GPU 卡集群,达到 90% 的扩展性。同时,该评测也是在 AIStation 的平台基础上进行开发,有效加速了浪潮DABNet4D算法的开发与训练。

自动驾驶技术发展撬动AI算力需求爆发

自动驾驶技术感知路线之争一直是行业关注的焦点,虽然特斯拉纯视觉方案在业内独领风骚,但多传感融合方案被业内视为实现自动驾驶安全冗余的关键手段。

为了更好的衡量3D检测效果,其评价指标已经从原来的2D的AP已经逐渐变为AP-3D和AP-BEV。在数据集的选择上也从KITTI逐渐变为更大和更多样的NuScenes数据集。

未来,基于LiDAR、相机等多源感知融合算法将有力地提升模型的检测精度,同时,Occupancy network、Nerf等先进算法模型也会逐步应用于自动驾驶感知模型的开发与训练中。

自动驾驶数据量急剧增大、自动驾驶感知模型复杂度逐步提升,以及模型更新频率逐渐加快,都将推动自动驾驶的蓬勃发展,也必然带来更大的模型训练算力需求。

免责声明:

※ 以上所展示的信息来自媒体转载或由企业自行提供,其原创性以及文中陈述文字和内容未经本网站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本网站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。如果以上内容侵犯您的版权或者非授权发布和其它问题需要同本网联系的,请在30日内进行。

※ 有关作品版权事宜请联系中国企业新闻网:020-34333079 邮箱:cenn_gd@126.com 我们将在24小时内审核并处理。

更多新闻,请关注

更多新闻,请关注标签 :

相关网文